Zeit Online

(Dies ist die Langfassung des Interviews, das ich mit Tim O’Reilly geführt habe. Sie enthält einige Passagen, die aus der Fassung von Zeit Online herausgekürzt wurden – ich fand sie interessant genug, um sie hier zu dokumentieren.)

Ist das Internet kaputt? Nein, sagt der Webvordenker Tim O’Reilly. Er glaubt immer noch an das Gute im Netz. Ein Gespräch über Geparden, Elefanten und Donald Trump

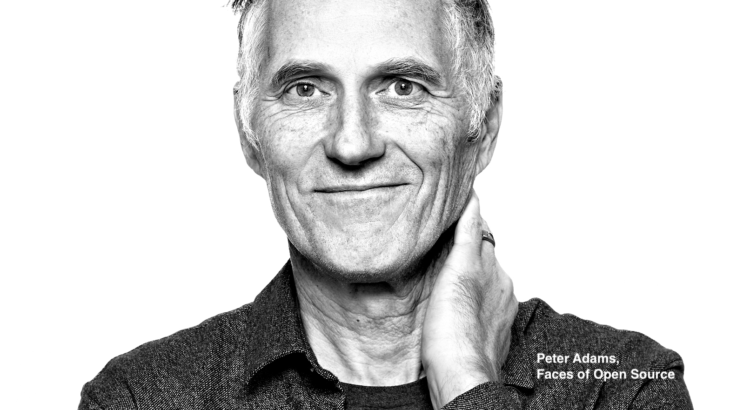

Er gilt als „Orakel des Silicon Valley“: Tim O’Reilly hat Begriffe wie „Open Source“ oder „Web 2.0“ populär gemacht. Als Gründer und CEO des Computerbuchverlags O’Reilly Media hat er mehrere Bücher verfasst – unter anderem über Windows, Twitter und Unix. In seinem jüngsten Werk „WTF? What’s the Future and Why It’s Up to Us“ beschäftigt er sich mit der Zukunft und der „nächsten Ökonomie“. ZEIT ONLINE hat ihn getroffen und mit ihm über den Hype um künstliche Intelligenz (KI), datenbasierte Politik und den Zustand des Internets gesprochen.

Herr O’Reilly, würden Sie lieber von einem Präsidenten wie Donald Trump regiert oder von einer künstlichen Intelligenz?

Das kommt auf die KI an genauso wie auf die Person.

Warum?

Genauso, wie es viele Arten von Lebewesen gibt, wird es wahrscheinlich auch viele Arten von KI geben. Und sie werden unterschiedliche Begabungen haben. Ein Pferd oder ein Gepard rennen ja auch schneller als wir Menschen, trotzdem können wir andere Dinge besser als sie. Also müssen wir eher über spezifische Fähigkeiten reden.

Zum Beispiel?

Vertrauen Sie den Routenempfehlungen von Google Maps mehr als denen eines durchschnittlichen Passanten auf der Straße? Ich schon. Und ich kann mir eine algorithmische Intelligenz vorstellen, der ich eher das Management unserer Außenpolitik oder unserer Wirtschaft anvertrauen würde als Donald Trump.

Typische gesetzliche Regelungen werden einmal in Gang gesetzt und sollen dann 10, 20 oder gar 50 Jahre halten – das funktioniert nicht mehr.

Tim O’Reilly

Alle legen immer die Latte für KI so unglaublich hoch. Warum legen wir strengere Maßstäbe an sie an als an Menschen? Haben Menschen wirklich Selbstbewusstsein? Denken Sie an die ganzen unbewussten Verhaltensweisen, die wir an den Tag legen. Warum verlangen wir dann von einer KI Bewusstsein? Lernen Menschen unüberwacht? Ohne überwachtes Lernen würden unsere Kinder sich nicht gut entwickeln. Warum erwarten wir das dann von Künstlichen Intelligenzen? Der wahrscheinlichste Weg zur KI ist der von Hybriden zwischen Menschen und Maschinen, und davon gibt es schon einige.

Sie haben einmal gesagt: Unsere Wirtschaft wird schon von einem Algorithmus gesteuert, es ist nur der falsche.

Es gibt eine Menge Parallelen zwischen unseren heutigen algorithmischen Systemen und großen Firmen. Beide sind Optimierungsmaschinen. Googles Suchmaschine nutzt hunderte von Algorithmen, inklusive einiger Deep-Learning-Verfahren, um die Relevanz der Ergebnisse zu optimieren. Hat der Nutzer gefunden, was er gesucht hat, was man daran sieht, dass er nicht zur Suche zurückkehrt? Unsere Wirtschaft ist auch rund um solche Optimierungen gebaut. Die nationalen Notenbanken versuchen Arbeitslosenquote und Inflation zu optimieren und die Wirtschaft weiter wachsen zu lassen.

Und oft optimieren diese Maschinen die falschen Dinge. Facebooks Algorithmen optimieren die Zeit, die die Nutzer auf der Seite verbringen, und suchen nach Inhalten, die sie fesseln. Dahinter steckte auch die Vorstellung, dass das die Menschen zusammenbringen würde. Heute wissen wir, dass das ein Irrtum war. Seit den 70er Jahren wurden in Firmen der Shareholder Value optimiert, in der Annahme, dass dadurch der allgemeine Wohlstand steigen würde. Aber heute wissen wir, dass Ökonomen wie Milton Friedman, die diese Idee vertreten haben, sich geirrt haben. Aber die Firmen optimieren weiterhin den Shareholder Value, auch wenn es den Mitarbeitern, der Umwelt und der Gesellschaft schadet. Das ist das größte Risiko der KI: dass wir der Maschine sagen, was sie tun soll – und sie tut es ohne Rücksicht auf Verluste.

Meine Eingangsfrage spielt auf eine Idee an, die Sie 2011 veröffentlicht haben: Sie wollen eine „algorithmische Regulierung“, damit meinen Sie den Einsatz von Algorithmen in der öffentlichen Verwaltung. Was wollen Sie damit erreichen?

Stimmt, der Name war nicht glücklich gewählt. Worauf ich hinaus wollte: Technologiefirmen haben eine sehr interessante Entdeckung gemacht: Man kann die Ergebnisse seines Tuns messen und aufgrund neuer Daten seine Beurteilung ändern. Typische gesetzliche Regelungen dagegen werden einmal in Gang gesetzt und sollen dann 10, 20 oder gar 50 Jahre halten – das funktioniert nicht mehr. Wir müssen der Regierung helfen, schneller aus ihren Fehlern zu lernen.

Ein Beispiel: Trumps großer Steuererlass für große Firmen vor zwei Jahren wurde verkauft als ein Mittel, die Firmen zum Investieren zu verleiten. Es hat sich aber herausgestellt, dass das nicht funktioniert hat – die Investments sind ausgeblieben. Nach Ihren Vorstellungen würde man also messen, ob das Erwartete eingetreten ist, und wenn nicht, wird das Steuergeschenk wieder kassiert?

Ganz genau. Und wenn man es schlau macht, würde man vorher noch eine Menge Tests machen, bevor man es an die Allgemeinheit ausrollt. Aber natürlich hat niemand in unserem politischen System wirklich geglaubt, dass die Steuersenkung diesen Effekt haben würde. Das war nur die Geschichte, mit der sie verkauft wurde. Ich glaube nicht, dass unsere Politik auf dem ernsthaften Glauben an diese Wirkungen basiert. Gewisse Interessengruppen sagen “Das ist besser für uns, also solltet Ihr das machen.”

Nun könnte man argumentieren, dass unser politisches System nicht gemacht ist für solche schnellen Methoden der Entscheidungsfindung.

Dann brauchen wir vielleicht ein neuartiges politisches System.

Wie soll das aussehen?

Stellen wir uns Google für einen Moment als Regierung des Internets vor. Die Suchmaschine hat ja bestimmte Kriterien, nach denen sie eine Website als nützlich einstuft – zum Beispiel, wie viele Leute auf eine Seite verlinken, wie viel Zeit Menschen dort verbringen, ob sie gleich wieder in die Suche zurückspringen und so weiter. Google hat dadurch definiert, wie gute Seiten aussehen. Als Google 2011 entdeckte, dass Content-Farmen …

… also Anbieter, die in möglichst großen Mengen Texte oder Videos produzieren und veröffentlichen, deren Hauptziel es ist, möglichst viele Klicks zu generieren …

… als Google also entdeckte, dass die lausige Inhalte ins Netz stellten, die von der Suchmaschine für gut befunden wurden, hat es den Algorithmus geändert und viele dieser Firmen vom Markt gefegt. Ich bin Fan einer stärkeren, an Prinzipien orientierten Regierung, die wirklich für die Menschen funktioniert. Und das heißt eben auch, schnell Dinge zu überdenken.

„Ablehnung von Maschinen ist nicht die richtige Antwort“

Google kann das von einem Tag auf den anderen tun, die Politik kann das oft nicht so einfach.

Aber wenn wir uns eine bessere Regierung vorstellen, wäre sie datengetrieben und würde eindeutige Ziele formulieren. Stattdessen haben wir diesen Vetternwirtschaftskapitalismus, in dem einzelne Interessengruppen zu viel Einfluss haben. Das ist, als würde sich Google mit den Spammern an einen Tisch setzen und mit ihnen verhandeln, welches Stück vom Kuchen sie abbekommen. Ich denke nicht, dass wir „das Internet“ reparieren müssen, sondern wir müssen etwas an der Tatsache ändern, dass es Gruppen von Menschen mit sehr engen Partikularinteressen gibt, die die Welt als Geisel halten und uns daran hindern, die Probleme anzugehen, die für den Rest der Menschheit sehr bedeutend sind. Offen gestanden, wir brauchen eine Regierung, die sich genauso am öffentlichen Interesse orientiert wie die Techfirmen in ihren besseren Tagen am Wohl ihrer Nutzer.

Wird China das erste Land sein, das Algorithmen und KI ernsthaft im öffentlichen Bereich einsetzen wird? Dort gibt es keine Beschränkungen durch Demokratie.

Kann sein. Ich glaube, China hat ein paar ernste wirtschaftliche Probleme. Ich war kürzlich da, es scheint im Immobiliensektor ein regelrechtes Ponzi-Schema zu geben. Sie bauen und bauen, um die Beschäftigung hoch zu halten, aber es gibt überall leer stehende Neubauten. Ich glaube aber, dass wir tatsächlich ein paar ernsthafte Fragen stellen müssen, ob Demokratien der richtige Weg nach vorne sind. Die Ökonomin Marjorie Kelly, die ich sehr verehre, hat gesagt: Wir haben den Fehler gemacht, eine politische Demokratie ohne eine Ökonomische Demokratie zu schaffen. Und nun haben wir eine ökonomische Oligarchie neben einem vermeintlich demokratischen System. Und diese ökonomische Oligarchie übertrumpft die demokratische Politik.

Erst einmal klingen Maschinen mit einer kühlen Intelligenz, die von uns formulierte Ziele umsetzen, großartig. Aber immer wieder geraten Systeme in die Kritik, etwa beim Einsatz von KI im Strafvollzug. Dort entscheiden sie in den USA mit darüber, wie hoch eine Kaution angesetzt wird oder sogar über eine Inhaftierung. Viele lehnen es ab, dass Maschinen diese Aufgaben übernehmen.

Ich glaube nicht, dass Ablehnung die richtige Antwort ist. Die vorhersagenden Algorithmen der Polizei und Justiz haben uns gezeigt, wie vorurteilsbeladen die existierenden Systeme sind. Die Algorithmen sind schlecht, weil wir sie auf der Basis jahrzehntealter Daten trainiert haben, die Vorurteile enthalten. Es ist nicht richtig, jetzt zu sagen: „Die Systeme zeigen uns, dass wir in der Vergangenheit versagt haben; statt sie zu verbessern, lassen wir wieder Menschen entscheiden oder Systeme, die die Daten produziert haben, die wiederum den Algorithmus schlecht trainiert haben.“ Das kann doch nicht richtig sein. Die Algorithmen halten uns nur den Spiegel vor.

Mir gefällt eine Idee, die Kevin Kelly 2011 formuliert hat: Wir sollten eine “Protopie” anstreben, keine Utopie. Eine Gesellschaft, die kontinuierlich besser wird. Sie ist nicht perfekt, wir haben nicht auf alles die richtigen Antworten, aber wir machen Fortschritte.

Paul Cohen, der früher das KI-Programm der Darpa geleitet hat und heute Informatik-Dekan an der University of Pittsburgh ist, hat gesagt: “Die Chance der KI ist es, Menschen dabei zu helfen, komplexe interagierende Systeme zu modellieren und zu managen.” Diese Verfahren können uns helfen, klüger zu sein und schneller zu reagieren.

Das ultimative komplexe Problem sind der Klimawandel und seine Konsequenzen, oder?

Stimmt. Und eines der Probleme, das über den Klimawandel hinaus das 21. Jahrhundert prägen wird, ist der Konflikt zwischen Ländern mit schrumpfender Bevölkerung und vielen Robotern und Ländern mit einer schnell wachsenden Bevölkerung mit wenig Robotern. Es wird also nicht die gesamte Menschheit gegen die Roboter kämpfen, sondern Menschen mit Robotern gegen Menschen ohne Roboter. Und es ist sehr wahrscheinlich, dass sich aus den Gesellschaften mit vielen jungen Menschen und wenig Robotern die Klimaflüchtlinge rekrutieren. Und die reichen Länder werden ihre Roboter dazu nutzen, diese Flüchtlinge draußen zu halten.

Wie können wir unsere Werkzeuge proaktiv zur Lösung dieser Probleme einsetzen? Ich habe zum Beispiel auf Google eingeredet: “Ihr wollt mich wohl veralbern – ihr wollt die Stadt der Zukunft für reiche Tech-Arbeiter in Toronto bauen? Baut doch lieber das Super-Flüchtlingslager der Zukunft. Findet heraus, wie man aus Flüchtlingen Siedler macht, aus Lagern produktive Städte. Könnte ein syrisches Flüchtlingslager zum nächsten Singapur werden, nur zu einem Singapur der Nachhaltigkeit? Das wäre mal ein Ziel, denn wir werden Hunderte von Millionen Menschen umsiedeln müssen.

Wenn man sich diese Großprobleme auf der politischen Ebene anschaut, dann ist ihnen allen gemein, dass man jetzt in ein System eingreifen muss, das man nicht vollständig durchschaut. Die Bremser sagen ständig: Wir müssen erst alles verstehen, bevor wir handeln können. In der algorithmischen Welt ist das der Normalzustand, oder?

Genau. Man lernt unterwegs, und schneller lernen ist die Devise. Ich glaube nicht, dass Deep Learning der Weisheit letzter Schluss ist in der KI, für viele Zwecke mag es sogar eine Sackgasse sein, aber seine Fähigkeit, nicht vollständig verstandenen Daten zu arbeiten, gehört zu seinen Stärken. Man füttert eine Menge Daten hinein, sagt dem System, dass man nach etwas sucht, aber nicht weiß, wie man es finden kann. Und das ist ziemlich cool.

Sie galten lange als Technikoptimist und glaubten insbesondere an das Internet und seine befreienden Kräfte. In den vergangenen Jahren haben gerade soziale Medien, die ja eigentlich angetreten waren, die Menschheit zu vernetzen, viel Kritik abbekommen: Durch Microtargeting, also individuelle Werbung auf Basis sensibler persönlicher Informationen, sollen sie Radikalisierung und Manipulationsmöglichkeiten im Netz gefördert haben. Hat die Kritik Sie dazu gebracht, einige Ihrer Überzeugungen zu hinterfragen?

Nicht wirklich. Das Internet wird vielfach als Sündenbock missbraucht.

Wie meinen Sie das?

In Ihrem Buch Network Propaganda haben sich Yochai Benkler und seine Harvard-Kollegen die Verbreitung von Verschwörungstheorien im Internet angeschaut und herausgefunden, dass Theorien vom linken Rand des politischen Spektrums durch die linkslastigen Mainstreammedien abgemildert wurden, während die Ideen vom rechten Rand durch den rechten Mainstream verstärkt wurden. Das Microtargeting mit Desinformationen auf Facebook mag eine Rolle gespielt haben in der US-Wahl, aber ehrlich gesagt hatte die institutionalisierte Desinformation durch sogenannte Traditionsmedien wie Fox News wahrscheinlich einen viel größeren Einfluss. Will ich, dass sich Facebook bessert? Ja. Aber ich will auch, dass sich Fox News oder die New York Times verbessern.

Gerade Facebook wird gern zum Sündenbock gemacht. Man hört längst nicht so viel über YouTube, und das ist mindestens so schlimm oder sogar noch schlimmer.

Tim O’Reilly

Aber sind Facebook und andere Techfirmen heute nicht mächtiger als Fox News oder die New York Times?

Es läuft sicherlich einiges schief mit diesen Plattformen. Wenn Sie jedoch Facebook mit den großen Pharma-, Öl- und Tabakfirmen vergleichen, dann hat die Firma doch recht schnell reagiert. Facebook hat Zehntausende von Leuten eingestellt, die nach Fake-News suchen, das Netzwerk gibt Mittel für technische Innovation auf diesem Gebiet aus. Vergleichen Sie das mal mit der Antwort der Tabakkonzerne auf die Erkenntnisse über Lungenkrebs, den Umgang der Ölkonzerne mit dem Klimawandel oder die Reaktion der Pharmaindustrie auf die Opioid-Krise. Oder auch mit den Banken an der Wall Street, die 2009 fast die Weltwirtschaft versenkt haben. Dagegen sehen die Techfirmen noch ziemlich gut aus. Außerdem wird gerade Facebook gern zum Sündenbock gemacht. Man hört längst nicht so viel über YouTube, und das ist mindestens so schlimm oder sogar noch schlimmer. Ich würde mich freuen, wenn wir eine nuanciertere und von Daten gestützte Debatte führen würden, statt einen Schuldigen auszumachen, ohne die anderen Spieler in diesem System unter die Lupe zu nehmen.

Auch darüber hinaus gibt es viel Kritik daran, wie Technologie eingesetzt wird. Es geht auch um intransparente Algorithmen, um Gesichtserkennung, um Kameras, die uns ständig anstarren, um Firmen, die unsere Internetaktivitäten tracken. Generell um ein Gefühl der Machtlosigkeit.

Ich habe meine Probleme mit Gesichtserkennung. Denn die ermöglicht wirklich dystopische Szenarien, gerade im politischen Kontext. Ein repressives System kann sie nutzen, um Menschen auf Schritt und Tritt zu verfolgen. Wir sehen schon heute einige düstere Dinge in China, die auf Gesichtserkennung basieren. Aber auf der anderen Seite gibt es auch Chancen. Will ich, dass mein Auto mich analysiert und erkennt, wenn ich wegdöse? Auf jeden Fall.

„Das große Problem ist die massive Machtasymmetrie“

Möchten Sie auch, dass Ihre Versicherungsgesellschaft davon erfährt?

Das Problem ist nicht, dass man Daten sammelt, sondern ob sie für oder gegen mich verwendet werden. Der Ansatz „Wir müssen das Datensammeln verhindern“ ist falsch. Datenschutz im Gesundheitswesen ist so ein großes Thema, weil Versicherungen diskriminieren. Und dafür müssen wir nicht Datensammlungen verhindern, sondern die Diskriminierung. Auch wenn das vielleicht nicht leicht ist.

Ist das Problem nicht eher, dass wir nicht wissen, wer die Daten bekommt und was damit geschieht?

Wir müssen nach vorn denken, nicht rückwärtsgewandt. Das große Problem dieser Systeme ist die massive Machtasymmetrie. Wir müssen Menschen in die Lage versetzen, diesen Großsystemen auf Augenhöhe zu begegnen. Warum soll ich nicht eine Maschine haben, die nur für mich arbeitet, mich beschützt, meine Präferenzen formuliert? Manche Leute denken über persönliche KI-Systeme nach, deren Mission es ist, zum Beispiel auf Tim aufzupassen und ihn vor all den anderen Maschinen zu beschützen, die ihn übervorteilen wollen.

Nehmen wir mal die europäische Datenschutz-Grundverordnung als Beispiel: Die hat dazu geführt, dass uns jede Website mit einem Pop-up-Fenster zum Datenschutz begrüßt, das wir sofort ungelesen wegklicken. Was könnte eine Maschine da machen?

Wir bräuchten eine Maschine, die mit der Maschine auf der Gegenseite aushandelt, welche Daten gesammelt werden dürfen, und die anzweifeln kann, ob die Gegenseite die wirklich braucht. Wobei sich manche Firmen meiner Ansicht nach schon gebessert haben. Auf Android gibt Google inzwischen einen sehr detaillierten Überblick, welche Apps Ortsdaten verlangen, und fragt mich, ob ich das okay finde. Und das ist gut, Google arbeitet für mich.

Aber Selbstregulierung funktioniert gewöhnlich nicht. Es bleibt bei Versprechungen, wenig ändert sich wirklich. Will man das Thema ernsthaft den Firmen überlassen?

Sicher nicht. Das ist eine Aufgabe für Regierungen. Wir sehen aber auch, dass im privaten Sektor gegenläufige Ansätze entstehen. Ein gutes Beispiel sind Adblocker, sie sind der Anfang einer defensiven persönlichen Technik. Ich kann mir vorstellen, dass aus diesem Versprechen eine großartige Technologie-Plattform erwächst, die das nächste Äquivalent zu Firefox sein wird.

Was halten Sie von einer digitalen Charta für Grundrechte, wie sie zum Beispiel in Deutschland entwickelt wurde?

Ich bin skeptisch bezüglich solcher sogenannten digitalen Chartas. Die Leute, die sie verfassen, verstehen Technik meist nicht sehr gut. Und sie kommen dann mit Forderungen, die gut klingen, aber nicht wirklich umsetzbar sind. Das heißt nicht, dass nichts Gutes dabei herauskommen kann. Aber ich habe an vielen Diskussionen teilgenommen, die sich anfühlten wie die Geschichte von den blinden Menschen und dem Elefanten: Jeder sieht Teilaspekte der Geschichte, aber keiner hat das große Ganze im Blick.

Hat die europäische Datenschutzdiskussion eine Auswirkung auf die amerikanische Debatte gehabt?

Ich glaube ja. Auch wenn sie von den Firmen vor allem als Belästigung empfunden wurde, von kleinen und mittleren mehr als von den ganz großen.

Jede Firma, die weltweit operiert, muss sich jetzt an europäische Regeln halten – das ist ein großer politischer Erfolg.

Ist es, aber es ist nicht unbedingt gute Politik. Schauen Sie sich meine Firma an: Die DSGVO hat es uns viel schwerer gemacht, Europäer zu unseren Foo-Camp-Events einzuladen. Früher haben wir von dieser coolen, interessanten Wissenschaftlerin gehört und ihr einfach eine Einladung geschickt. Nun müssen wir erst jemanden finden, der die Verbindung herstellt – obwohl die Leute sich wahrscheinlich freuen würden, von uns eine Email zu bekommen.

Ein typisches Beispiel für das, wovon wir am Anfang gesprochen haben: Ein großes Gesetz wird beschlossen, und dann bemerken die Leute all die kleinen, unnötigen und nicht intuitiven Fehler im System. Wenn man da an den Knöpfen drehen und die Dinge justieren könnte …

Unsere regulatorischen Systeme tendieren dazu, auf Konflikte angelegt zu sein – tu dies nicht, tu jenes nicht. Daneben haben wir auch diverse ökonomische Anreize, aber die beiden sind nicht wirklich miteinander verbunden, und wir müssten wirklich ein integriertes System bauen.

Im öffentlichen Leben haben wir das in embryonaler Form in den Steuergesetzen und Subventionen. Die ähneln in vieler Weise den Interventionen von Google und Facebook, indem sie die Systeme formen, in denen sie operieren. Fundamentalistische Marktanhänger sagen, die Regierung soll ihre Finger vom Markt lassen, ohne dabei anzuerkennen, dass der Markt, wie er heute existiert, stark durch die Politik geformt worden ist.

Sie bezeichnen etwa den Steuererlass für Elektroautos als Marktintervention und sind blind für all die Subventionen, die bereits für fossile Brennstoffe existieren! In der Tech-Branche schauen wir auf die Systeme, die wir bauen, und verändern sie wenn sie ihre Ziele nicht erreichen. Anreize für regenerative Energien sind prima, aber sie wären noch besser, wenn man gleichzeitig die Anreize für fossile Energien zurückfahren würde. Und man kann differenzieren: Zum Beispiel hat Kalifornien gerade die Subvention von Elektroautos über einem gewissen Preis eingestellt, weil die Hilfe überwiegend an reiche Leute ging, die sie nicht brauchen.

Oder denken Sie an die Fettleibigkeits-Epidemie in den USA – die ist ein Produkt der Bauernsubventionen, die Maissirup zum billigsten Kalorienspender gemacht haben. Das ist ein Problem, das man leicht lösen könnte.

Aber es geht doch um die kleinen Farmer im mittleren Westen.

Nein, es geht um die großen Farmer im mittleren Westen. Das sind doch auch nur politische Geschichten. Verstehen Sie mich nicht falsch, ich bin kein Freund von Autokraten. Ich bin ein Fan einer stärkeren, an Prinzipien orientierten Regierung, die wirklich für die Menschen funktioniert.